반응형

내 맘대로 Introduction

이 논문도 이전 P2D 와 같이 discriminator가 pretrained model 기반으로 구성한 논문. 아쉽게도 초점이 T2I 모델을 GAN 기반으로 만들고 성능을 높여다는데 있다. pretrained model의 효과에 대해 분석하는 것이 아니라. 그래서 내 입장에선 참고 정도만 하기 좋은 논문이었다.

메모

|

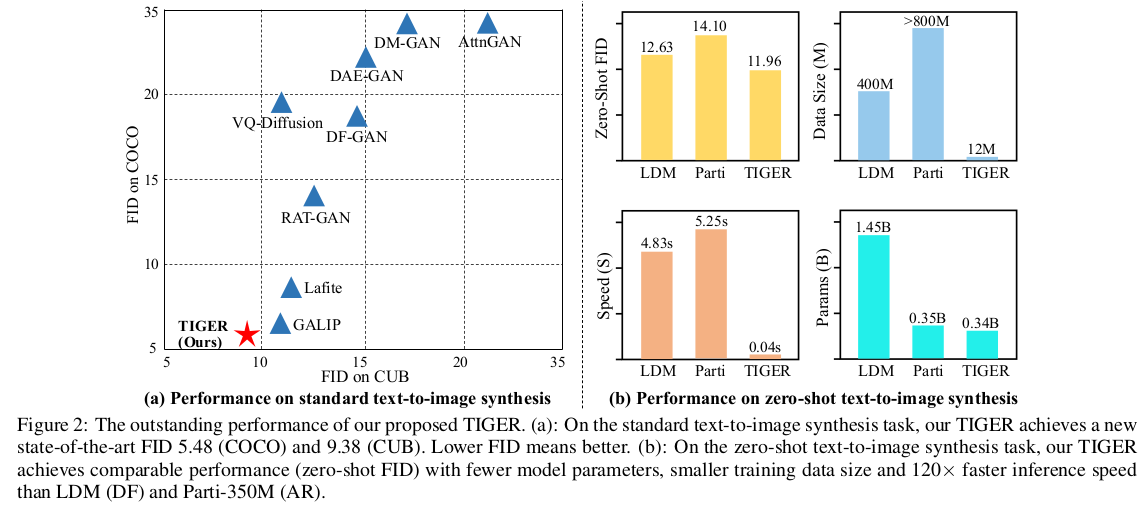

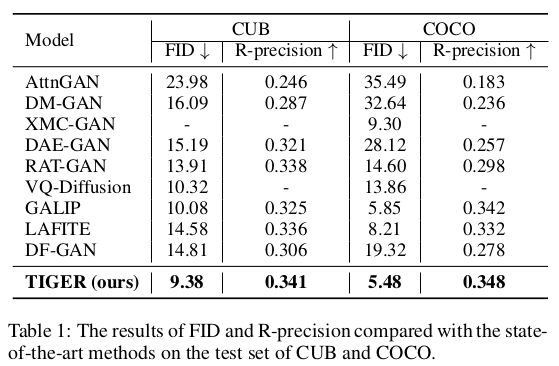

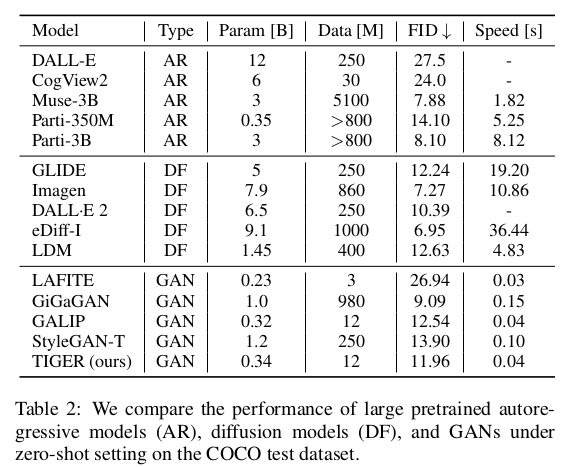

성능으로 compete하는 방향으로 논문 방향을 정했다. |

|

모델 구조를 어떻게 짰는지 설명 시작. 성능에 초점을 맞추고 있기 때문에 성능 gap을 조금이라도 올리기 위해서 네트워크 구조를 최적화했음을 먼저 설명한다. 아쉽지만 내 관심사는 아니어서 설명 패스. |

|

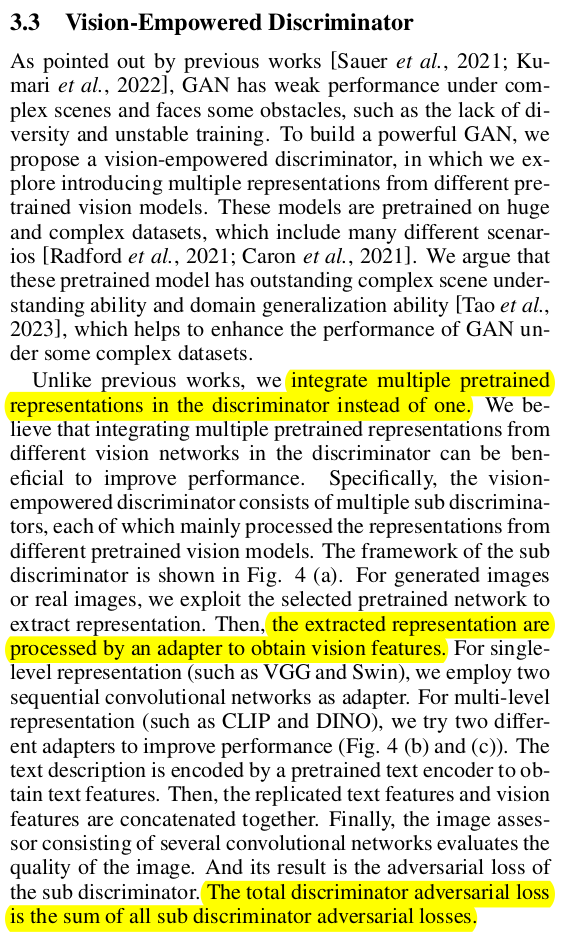

이것도 마찬가지. |

|

|

|

이 논문에서는 P2D와 다르게 네임드 모델들을 전부 다 붙여봤다. 이 결과는 좀 유의미한 것 같음.  결론부터 보면 CLIP 이후 DINO를 같이 썼을 때 성능이 좋았다고 함. 개인적으로 semantic feature를 잘 뽑기로 실험적으로 검증된 CLIP과 DINO가 역시나 좋은 결과를 보였다는 점에서 feature extractor가 짱짱할 수록 discriminator가 도움받는 건 확실하다는 증명인 것 같다. 금쪽이 discriminator 지만 좋은 backbone 붙여주는 건 여전히 좋다는 것. |

일부 Diffusion model도 제칠 수 있다는 점이 인상적. |

|

|

|

반응형