반응형

내 맘대로 Introduction

이 GS-LRM은 Adobe에서 만든거라 완성도가 매우 높지만 코드가 공개되지 않았기 때문에 유명세까지는 이어지지 않은 숨은 고수 같은 느낌이다. 논문으로써 바라보면, transformer + MLP(to-GS primitives)를 multiview setting에서 학습한 foundation model을 만든 것이라 technical report에 가깝다. 논문을 읽다 보면 저자들도 acceptance 여부보다는 report 느낌으로 남겨놓았다는 인상이 남는다. 내용은 매우 간결하다. 구현도 매우 간결. 하지만 학습 데이터 양에서 압도적인 수준을 보여주는 듯 하다.

단순히 보면 DUST3R 같은건데, GS primitives가 pixel마다 출력으로 나온다고 보면 됨.

메모

|

|

|

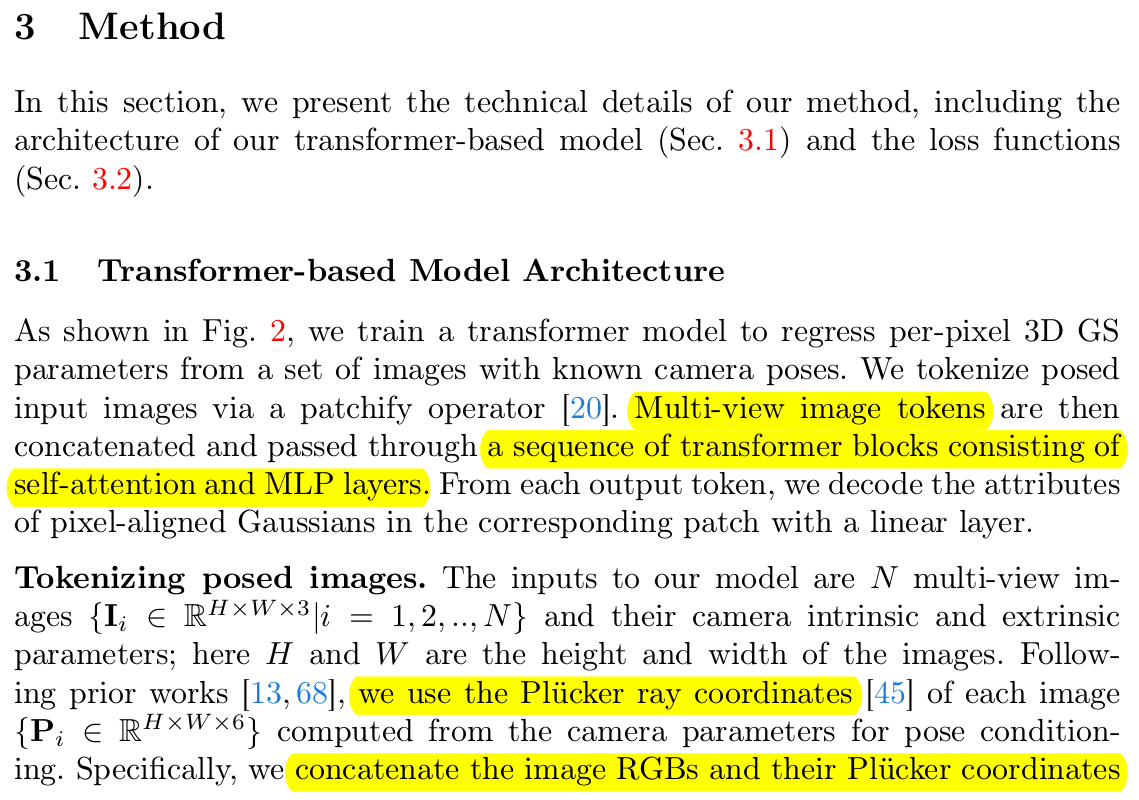

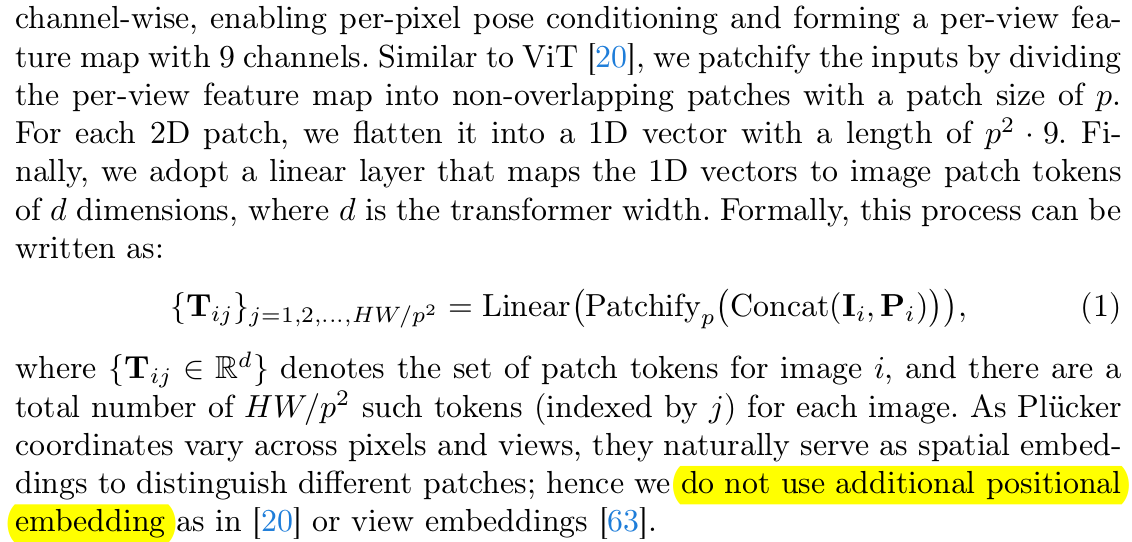

매우 간단하다. 1) Multiview image token으로 만들기 2) plucker coordinate를 positional embedding마냥 사용 -> RGB 뒤에 그냥 concat 해서 9채널로 사용 -> pos embedding은 따로 안함 3) self attention ~ |

|

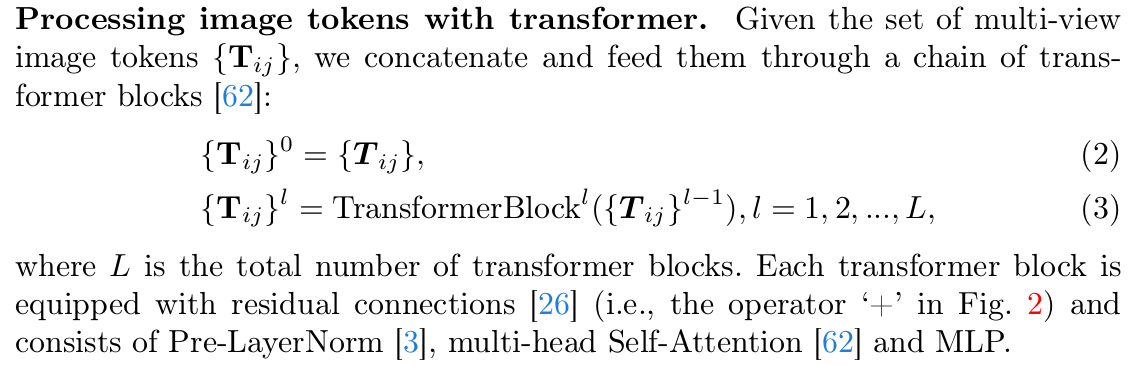

self attention + MLP가 반복됨. 그냥 implementation detail을 설명해준 것. |

|

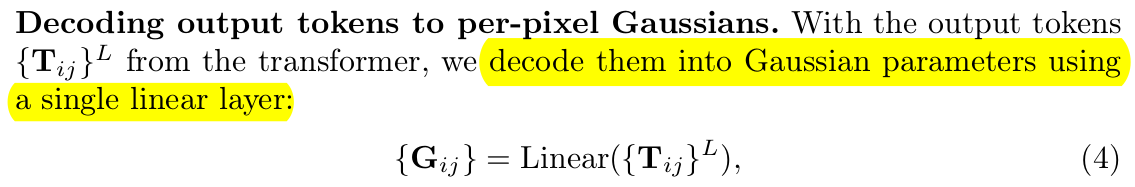

transformer token이 최종적으로 나오면 딱 1겹의 MLP를 통과시켜 per-pixel GS primitives로 변환 -> 여기서 confidence 같은 걸로 배경과 같은 빈 픽셀을 처리해줄 필요가 있지 않나? 라고 생각했는데 opacity가 GS에 이미 들어있어서 이게 0으로 가면 안보이니까 상관없을 듯. |

|

나 참 loss도 그냥 rendering loss 밖에 없다. 데이터가 이렇게 무섭다. |

성능 갭이 좀 크다. |

|

|

도메인을 넘나드는 커버 범위... |

앞에 multiview generation model을 붙여도 잘 동작함. multiview consistency가 조금 깨져도 GS-LRM이 어느 정도 커버해주는 듯. |

|

반응형