반응형

내 맘대로 Introduction

2022년 Diffusion을 활용하기 전 VTON 논문으로 이제는 오래됐다고 (2년 지났지만...) 볼 만한 논문. 하지만 2023년 GP-VTON도 그렇고 flow를 활용한 VTON 논문만이 갖는 장점을 확실히 있는 것 같다. Diffusion model이 아무리 잘 만든다 한들 사전 학습된 latent space로부터 최대한 유사한 이미지를 만들어내는 방식이다 보니 입력과 멀어지는 경우가 종종 있는데 flow는 입력을 직접 활용하는 방법이다 보니 확실히 장점이 있다.

단순 기록용으로 적는다.

메모

문제 정의는 똑같고, 핵심 아이디어는 1) semantic information 잔뜩 먹고 사전 학습된 flow 기반 네트워크를 teacher로 두고, semantic information 안 쓰는 flow 기반 네트워크를 학습시키기 (입력 단순화 하기) 2) 사전 학습된 네트워크를 활용하여 데이터 뻥튀기 하기. |

사전 학습된 flow 기반 네트워크는 segmentation map + openpose + densepose를 입력으로 먹고 학습된 아이. |

|

|

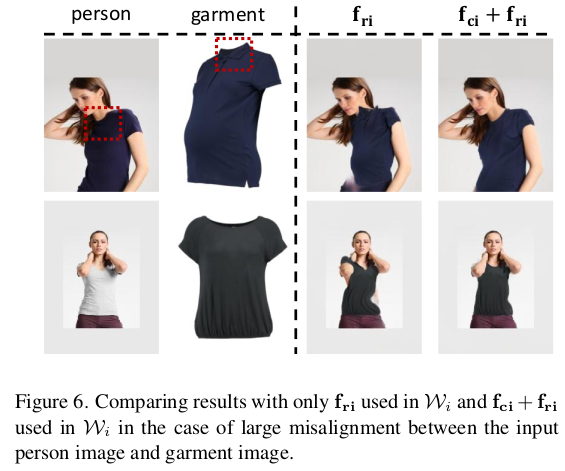

설명이 길지만, coarse to fine, grid_sample용 flow를 예측한다는 내용 입력 : 옷 이미지, 사람 이미지 출력 : flow 출력 2: 최종 옷입은 이미지 sampling이라고 표현되는 S가 F.grid_sample |

|

|

1) 생성 완료된 옷+사람 <=> GT 간의 perceptual loss를 주 loss로 사용함. -> pixel by pixel로 하지 않은 이유는 옷이 non-rigid 하다보니까 조금 다르게 generation된 것은 변형 가능한 범위라고 판단해주기 위함인 것 같음. -> 아니면 해봤는데 구렸거나 2) flow smoothness loss 3) teacher network의 distillation loss -> 이건 사실 숫자 싸움을 이기기 위한 트릭에 가까운 듯 함 -> network 구조에 제한이 생기는 것이라서 오히려 단점에 가깝다고 생각함. ------------------------ 코드 보니까 아니다. 이미지 pixel to pixel l1 loss도 사용함. 적어두지 않았음. |

|

|

|

|

|

|

반응형