반응형

내 맘대로 Introduction

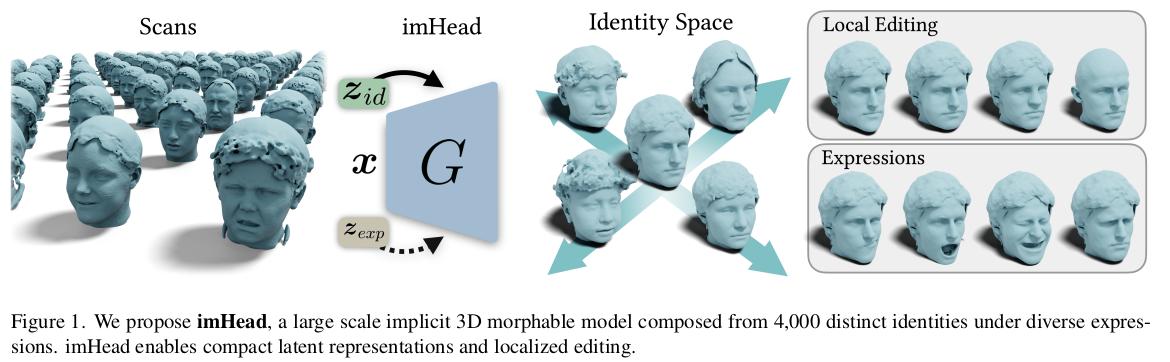

어쩌면 NPHM의 후속작이라고 불릴 수 있을 것 같은데, 약간의 Local controllability를 향상시키고 데이터셋의 범위를 크기 넓혀서 만들었다.

데이터셋을 4000 id 규모로 공개하고 학습에 이용했는데, 직접 스캔한 것을 이렇게 공개했나 하고 대단하다고 생각했었는데 있는 안면부 데이터를 completion해서 사용했다. MimicMe 데이터셋에 NPHM을 피팅해서 사용하는 방식 + 약간의 후처리를 곁들였다.

메모

|

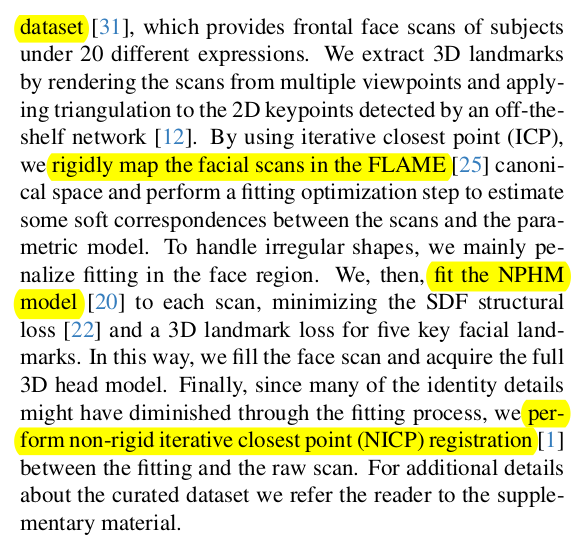

1. mimicme에서 4000개 subject 20개 expression 얼굴 스캔을 가져옴 2. FLAME fitting해서 좌표계 맞추고 스케일 맞추고. 3. NPHM을 피팅함. 4. NPHM mesh를 얻어낸 다음, 얼굴부만 NICP로 한 번 더 업데이트. 머리통 완성~ |

|

|

|

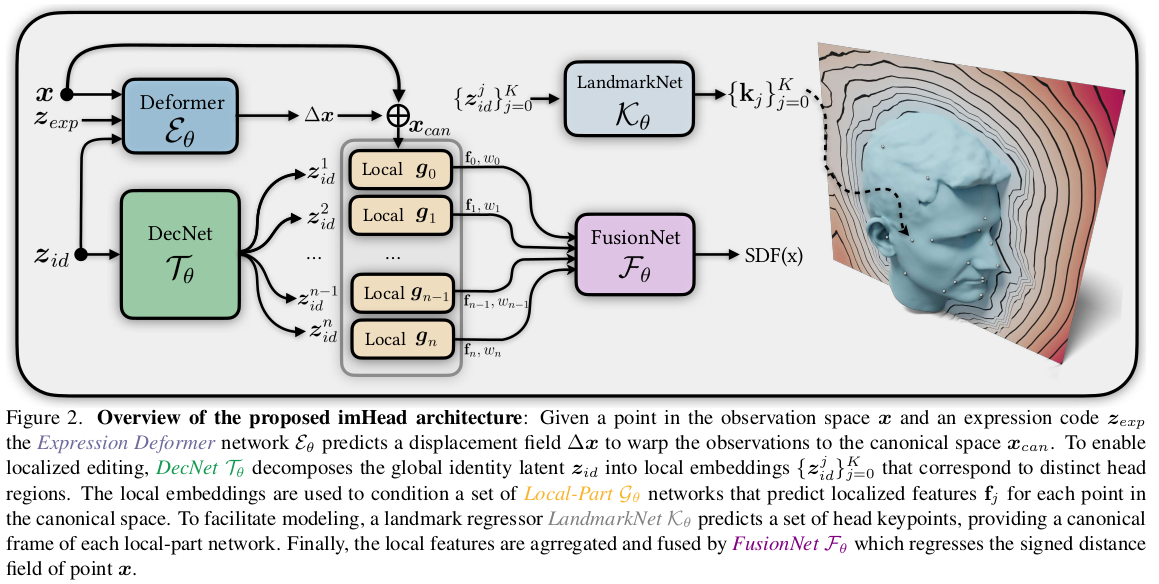

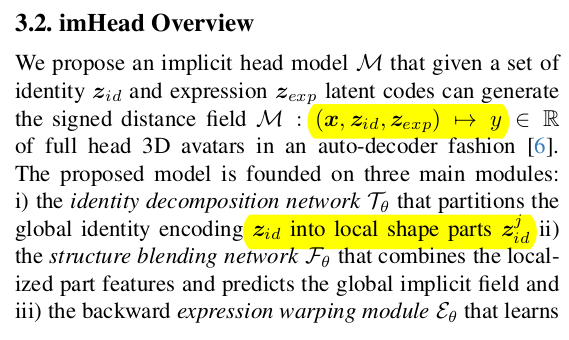

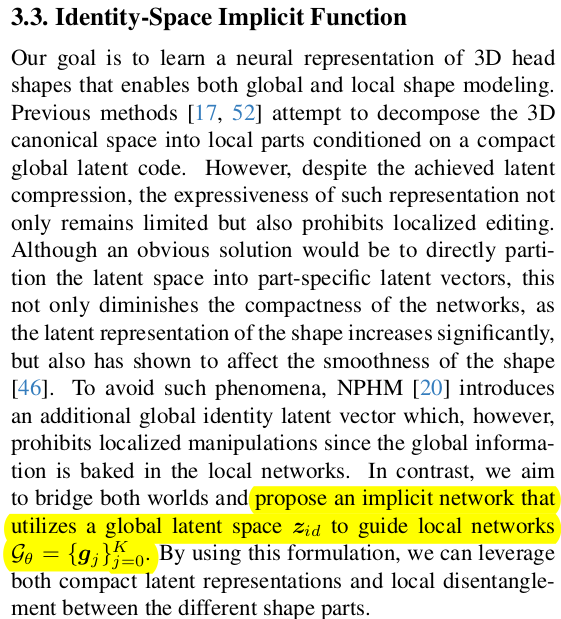

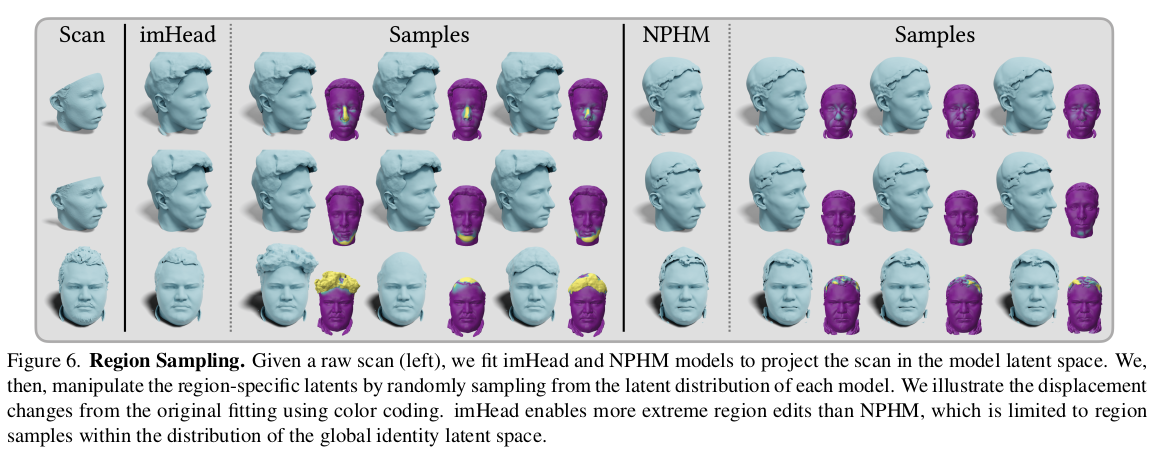

그림만 봐서는 유사해 보이나, NPHM 과의 차이는 local id를 많이 뒀다는 것이다. global id를 local id로 분산시키는 방식으로 구조를 짜서 local id를 교체하는 방식으로 local control을 강화했다. |

|

global id만 쓰면 global id 안에 각종 부분 정보가 aggregation되어 있을테니 당연히 분리가 어려움. control도 어렵고. 따라서 global id는 그대로 쓰되, local id로 쪼개주는 네트워크를 둠. |

|

local id는 각각 개별 local network에 의해 처리되고 local feature로 분리됨. local id 별로 정보 공유가 아예없기 때문에 앞에 global id to local id의 분리력이 강조됨. local part는 총 39개로 위 그림에서 보이는 점 위치와 같다. |

|

local feature는 또 해당 local region에 해당하는 keypoint에 relative position encoding된 query와 함께 한 번 더 처리됨 파트 별 f_j가 최종 부수적으로 local id가 들어갔을 때 keypoint 뱉어주는 landmark net도 같이 학습함. |

|

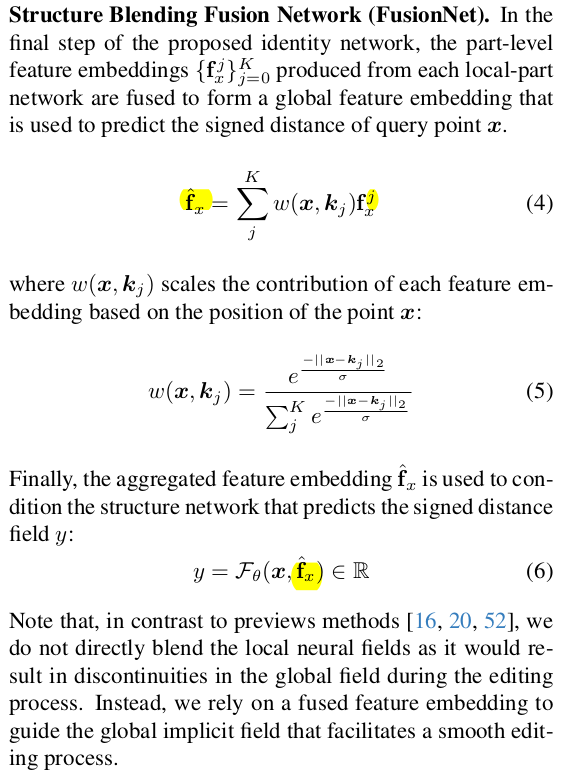

파트 39개 마다 겹치는 영역이 없는게 아니기 때문에 블렌딩이 필요한데 최종 sdf를 블렌딩하는게 아니라 feature level에서 블렌딩한다. landmark와 query가 떨어진 거리를 weight 삼아 local feature들을 aggregation해서 하나로 뭉쳐주고 decoder가 이걸 sdf로 바꿔줌. |

|

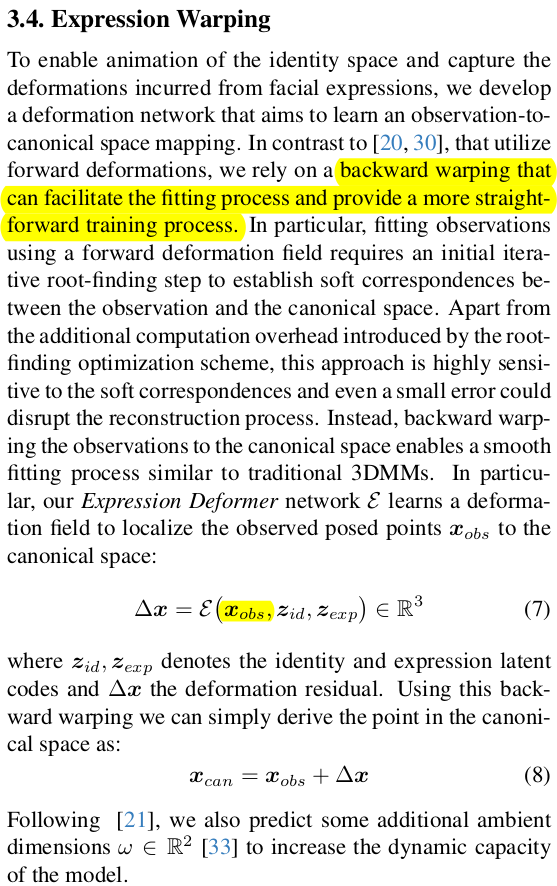

말이 길지만 observation-to-canoncial 즉 표정 있는 상태에서 표정 없는 상태로 보내는 방향의 expression warping이 유리하다는 점을 얘기하는 것 우리가 실제 스캔을 갖고 있고 이걸 모델로 표현하고자 하면 표정이 있는 스캔 데이터를 canonicalize하는 방향임. 네트워크 자체도 입력이 이 방향으로 맞춰져 있어서 스캔을 때려넣고 바로 쓸 수 있어서 좋음. scan에서 뽑은 query + global id, global expression이 들어가면 displacment vector가 나오는 식. 이걸 scan query에 더해주면 canonical query가 나온다. |

|

학습을 surface point의 SDF만 0으로 만들도록 해서 했다는데 이게 가능한건지 싶다. 전부 다 0으로 가는 식으로 학습될 수도 있으니 off-the-surface point에 sdf를 같이 걸어주곤 하는데 여긴 안 했다고 한다. 이외에는 eikonal loss나 landmark loss 정도 추가하고 학습함. |

|

|

NPHM보다 잘되는 것은 데이터의 확장이 제일 클 것 같고, local id의 추가라기보단 학습의 완성도 차이일 것 같다. |

|

|

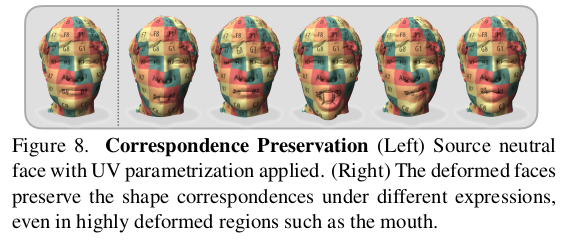

local id를 분리를 빡세개 하기 때문에 correspondence 가 좀 더 잘 유지되지 않을까 싶다. |

반응형

'Paper > Human' 카테고리의 다른 글

| Generative Human Geometry Distribution (0) | 2025.10.27 |

|---|---|

| Topologically Consistent Multi-View Face Inference Using Volumetric Sampling (0) | 2025.10.16 |

| GLVD: Guided Learned Vertex Descent (0) | 2025.10.16 |

| Learned Vertex Descent : A New Direction for 3D Human Model Fitting (0) | 2025.10.16 |

| 3DGH: 3D Head Generation with Composable Hair and Face (0) | 2025.08.06 |