반응형

내 맘대로 Introduction

masked image modeling 기법을 활용해서 transformer를 pretraining하는 방법이 유명해진 이후로 나온 논문이다. 이종 입력들, 이미지나 depth, normal 등,을 동시에 입력으로 받아 자가 학습하는 방법론을 설명한다. 내용 자체는 Masked auto encoder를 그대로 가져오면서 입력 개수와 출력 개수를 늘린 것이니 별 것 없어 보이지만 실제로 전혀 다른 이종 입력이 pretrain 레벨에서도 도움이 된다는 것을 보여줬다는 것에 의미가 있다. multimodal pretraining의 입문 같은 논문.

메모

|

|

|

설명할 내용은 별로 없다. MAE를 구성하는 건데 각각 다른 입력, 다른 encoder에서 나온 token을 받는 식으로 구성했다는 말. 각각 다른 token encoder 하나의 transformer 각각 다른 token decoder |

|

1) 각 입력마다 linear projection (token embedder)는 따로 둠 2) class token대신 global token이라는 걸 둠. 3) sine-cosine postional embedding 사용 4) modality마다 token을 두진 않음. modality token 보고 맞추는 식의 bias가 생길까봐 5) seg.seg는 class label을 64 dim으로 옮겨서 사용함 6) visible token만 사용함! (masked token은 다 버림) |

|

decoder를 무겁게 하면 연산량이 늘어나고 decoder에 의한 성능 향상이 주가 되버리므로 최대한 작게 함. 2 transformer block + cross attention + MLP임 |

|

masking이 많이 되어야 효과가 좋음 입력 당 196개 token이 나오는데 이중 1/6만 visible token으로 만들어 사용함 입력 3종류 사용해서 98 토큰 선별은 입력 상관없이 uniform (어느 한 입력token이 몰릴 수 있지만 그닥 심하지 않으므로 무시함.) 입력마다 token 개수 부여하는 방식으로 해봐도 큰 차이 없음. |

|

입력을 만드는 방식 RGB는 원래 있으니 그대로 사용함. 대신 (x-mean)/std와 같이 patch 별로 standardize한 RGB를 쓰기도 했다는데 크게 중요하진 않은 듯. 입력은 어쨌든 RGB 그대로 두었고 출력 단에서 standard된 것 안된것 2개 시도해봤다는 이야기. |

|

depth가 마련되어 있지 않은 데이터들도 있으니 이미지만 있다고 가정하고 아예 pseudo depth를 학습에 사용함. DPT-Hybrid 가져와서 극단적인 값들 10%씩만 버리고 사용함. |

|

sem.seg는 Mask2Former 사용함. |

|

모델은 VIT-Base 학습 시간은 128만장 이미지 갖고 400 epoch 또는 1600 epoch 정도 돌려서 성능 비교했다고 한다. |

|

|

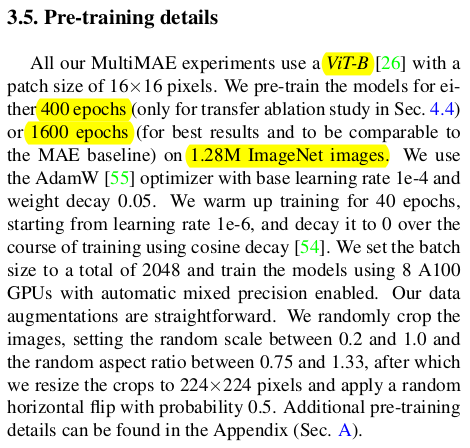

이종 입력 섞은게 성능이 많이 오르긴 하더라. |

|

|

|

|

|

위에 depth + 약간의 색상 patch 어떤걸 넣느냐에 따라 색상이 확확 바뀌는것으로 보아 정보가 서로 섞여서 돕고 있다는 것을 보여줌. |

반응형