Note

현재(2024.01.12)까지 나온 TensorRT 8.6.1까지 지원되는 cuDNN은 8.9.0만 있나 보다. 버전 선택지 없이 무조건 이걸로 깔아야 되는 듯 하다.

Document

https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html

Installation Guide - NVIDIA Docs

docs.nvidia.com

바로 가기 오류가 날 때가 있는데 url이 index.html로 끝나지 않는다면 index.html 이후는 삭제하면 잘 연결된다.

Installation

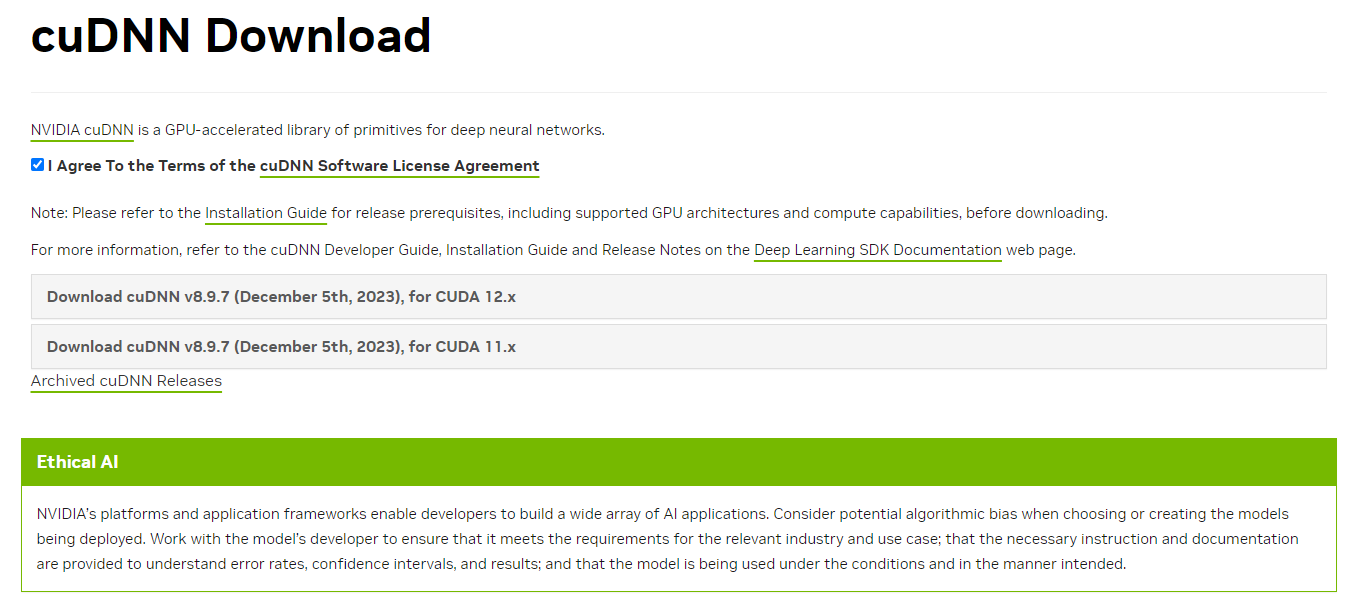

cuDNN 역시 NVIDIA developer progam 등록되어있어야 다운로드 가능하다. 간단히 이메일 인증만 거치면 된다.

최신 cuDNN부터 다운로드 안내가 되겠지만, TensorRT에서 지원하는 버전이어야만 하므로 previous arhives에서 8.9.0 for CUDA12.x를 받는다. (CUDA 11.x 쓰고 있다면 당연히 11) 2024년 1월 기점 이후로 TensorRT 지원 버전이 확대되면 맞춰서 변경하면 되겠다.

TensorRT를 deb 파일로 설치하면 CUDA, cuDNN도 deb파일로 설치되어 있어야 하므로 웬만하면 deb 파일로 설치하면 된다.

sudo dpkg -i cudnn-local-repo-ubuntu2004-8.9.0.131_1.0-1_amd64.deb

sudo cp /var/cudnn-local-repo-ubuntu2004-8.9.0.131/cudnn-local-80259EFB-keyring.gpg /usr/share/keyrings

CUDA deb 파일 설치할 때와 마찬가지로 dpkg 이후 keyring.gpg를 복사하는 과정이 있다. 역시나 이 과정을 여러번 반복하게 되면 /usr/share/keyrings 하위에 여러 cudnn-*.keyring.gpg 파일이 쌓여있으므로 설치 시도할 때마다 지워주는 것이 좋다.

### only when you reinstall or retry

sudo rm -f cudnn-*

sudo apt-get update

sudo apt-get install libcudnn8=8.x.x.x-1+cudaX.Y

sudo apt-get install libcudnn8-dev=8.x.x.x-1+cudaX.Y

sudo apt-get install libcudnn8-samples=8.x.x.x-1+cudaX.Y

sudo apt-get update를 미리 안해주면 불필요한 오류가 발생하니 꼭 순서 지켜서 입력하는 것이 좋다.

Check

libcudnn8-samples까지 install되었다면 /usr/src/cudnn_samples_v8 내 많은 예제들을 볼 수 있다.

그 중 MNIST 예제를 실행시켜 정상 결과가 나온다면 설치가 제대로 된 것이다.

cp -r /usr/src/cudnn_samples_v8/ $HOME

cd $HOME/cudnn_samples_v8/mnistCUDNN

make clean && make

./mnistCUDNN

# test passed!

'Knowhow > Others' 카테고리의 다른 글

| [TensorRT 튜토리얼] 3. TensorRT ecosystem (0) | 2024.01.19 |

|---|---|

| [TensorRT 튜토리얼] 2. Docker container (0) | 2024.01.19 |

| [TensorRT 튜토리얼] 1-1. CUDA installation (0) | 2024.01.19 |

| [TensorRT 튜토리얼] 1. Installing TensorRT (0) | 2024.01.17 |

| [ROS2 Foxy Tutorial 한글 번역] 13. Creating a package (0) | 2023.02.06 |