반응형

내 맘대로 Introduction

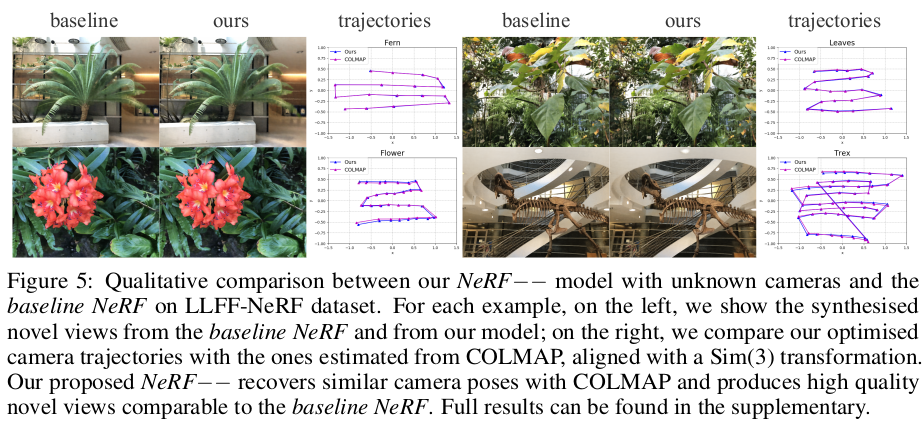

이 논문은 self-calibrating nerf, barf 와 같이 카메라 포즈도 같이 추정하는 nerf인데 내 기준 완성도가 가장 낮다. barf는 별 거 안해도 카메라 포즈 같이 최적화하는거 어느정도 된다 + 다만 positional encoding을 변화시켜주면 더 잘된다 중 후자는 그래도 의미가 있는데, 이 논문은 전자만 있다. 고로, contribution이 거의 없는 논문으로 보인다.

그냥 카메라 포즈랑 같이 최적화 해봤다 + 카메라 포즈가 얼마나 망가져 있어야 되고 안되고 그 정도를 분석해봤다 정도다. 보고서에 가까운 논문

메모하며 읽기

|

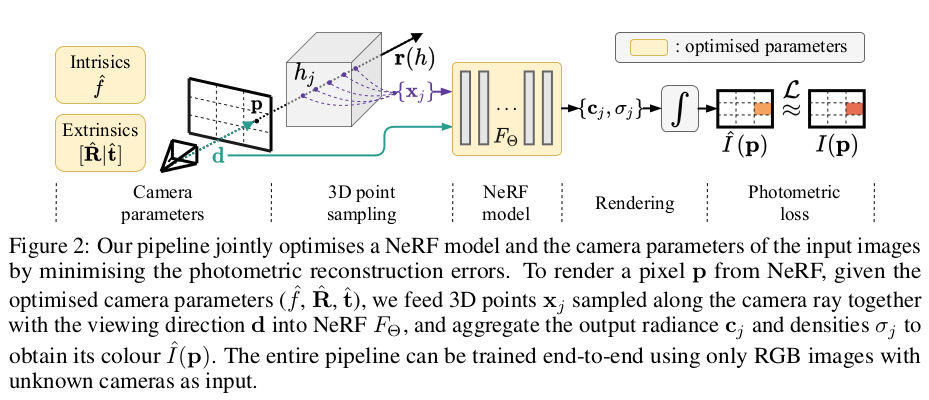

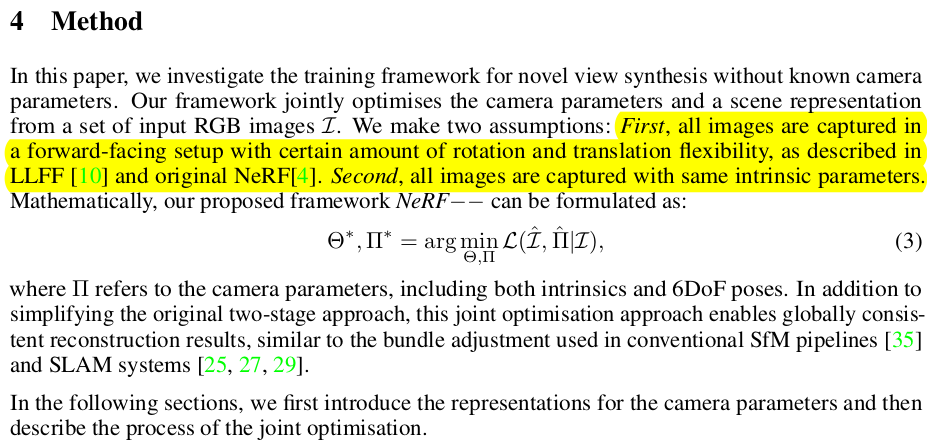

| 물체 바라보면서 하나의 카메라로 쭉 찍은 이미지들을 가정한다. |

|

| intrinsic은 fx, fy 퉁쳐서 f 하나, cx, cy는 이미지 해상도로 퉁쳐서 0개로 간소화해서 추정한다. (이 대목에서 실망을 많이 했는데 실제 사용할려면 무조건 fx, fy, cx, cy 형태로 찾아야 한다. 게다가 distortion도 있을텐데. 이렇게 한다는 것 자체가 그냥 논문 쓰려고 되는 형태로 축소했다고 밖에 안 보인다.) extrinsic은 axis-angle 로 3차원으로 찾는다. (이것도 참... axis-angle representation으로 하면 neuralnet으로 rotation 커버할 때 비효율적인데 그냥 쓴것도 아쉽다. 게다가 이렇게 표현하면 카메라 모션도 카메라가 고개 돌리는 모션 외에는 추정 성능이 떨어질텐데...) |

|

| 아무 내용 없음. 그냥 3d point, x가 learnable intrinsic, extrinsic 으로 표현된다는 당연한 이야기 |

|

| 이건 데이터셋이 contribution이라고 보기도 애매하다. 카메라 포즈가 얼마나 잘 보정되는지에 대한 정량 평가용 데이터셋인데 blender로 물체를 촬영한 이미지들을 만들었다. GT 카메라 포즈에 pertubation을 줘서 실험했다....(실제 사용성은 고려를 크게 안하는 듯) 즉, unknown camera parameter를 찾아준다기 보다 unstable camera parameter를 보정해주는 컨셉처럼 실험을 함. |

|

|

|

|

|

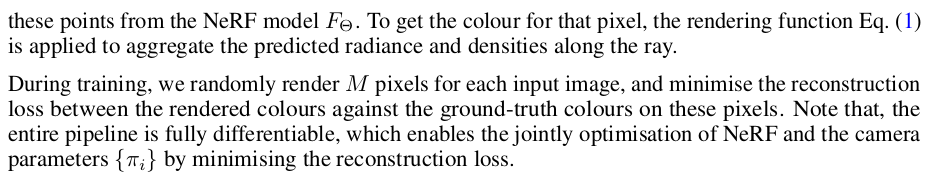

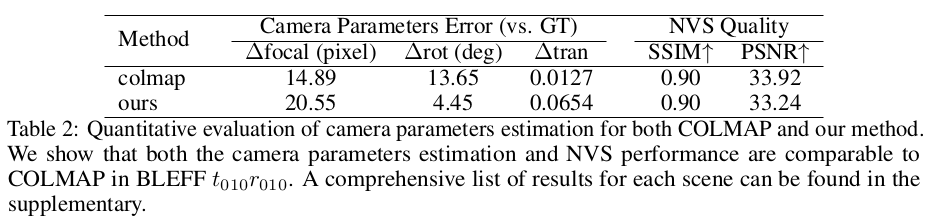

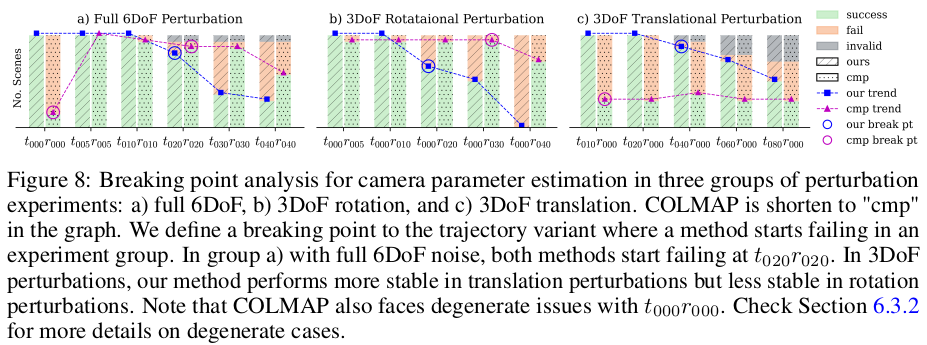

| 실험해보니 그냥 NeRF--처럼 카메라 포즈 약간 틀어진 정도를 보정하는 기능은 translation은 20%, rotation은 20도를 넘어가면 실패한다고 한다. (이정도 분석이 의미가 있는듯) |

|

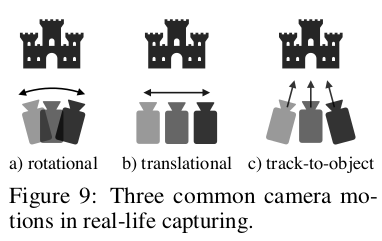

카메라 모션도 구분해보면 a) b)와 같은 모션은 잘되는데 (axis-angle representation의 한계인 듯?) c)는 잘 안됐다고 한다. (c)가 제일 중요한 모션 같은데...) |

|

|

반응형

'Paper > 3D vision' 카테고리의 다른 글

| DeDoDe: Detect, Don’t Describe — Describe, Don’t Detectfor Local Feature Matching (0) | 2023.11.02 |

|---|---|

| 3D Gaussian Splatting for Real-Time Radiance Field Rendering (0) | 2023.11.02 |

| BARF : Bundle-Adjusting Neural Radiance Fields (0) | 2023.10.30 |

| Self-Calibrating Neural Radiance Fields (0) | 2023.10.30 |

| Level-SfM: Structure from Motion on Neural Level Set of Implicit Surfaces (0) | 2023.10.30 |