반응형

내 맘대로 Introduction

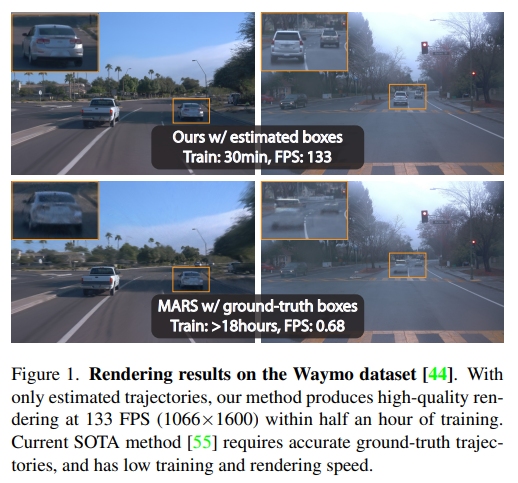

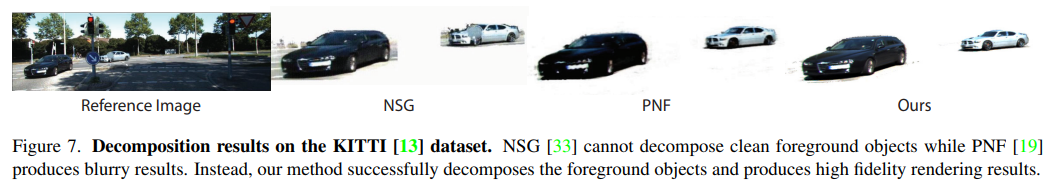

논문보다 프로젝트 보고서에 가깝다. 그냥 주어진 데이터셋에서 gaussian splatting 돌려보았고, tracker 활용해서 차량 분리해보았다. 그럼에도 불구하고 기록하는 이유는, 후반부 time parameter를 넣어 4D 로 확장할 때 기존 논문들과 달리 fourier transform을 썼다는 점이 독특했기 때문이다.

메모하며 읽기

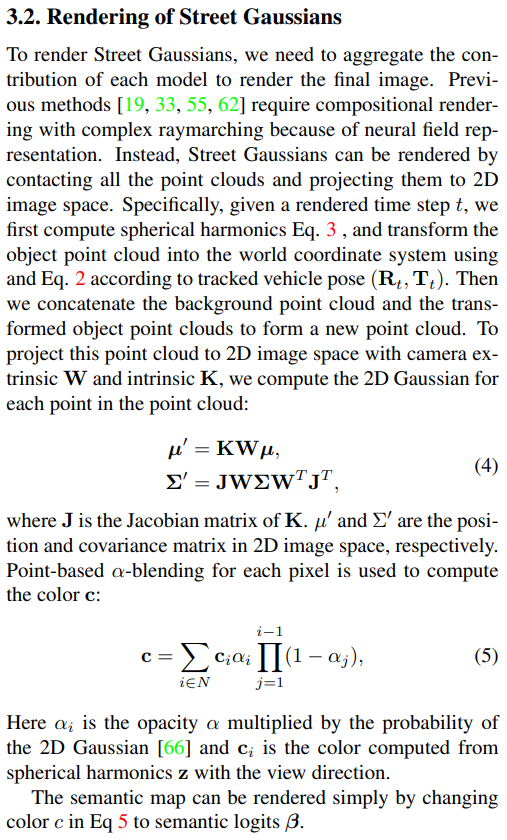

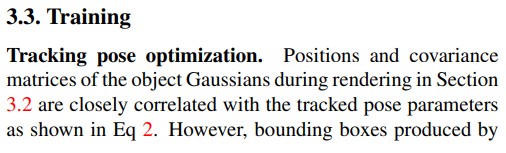

|

|

|

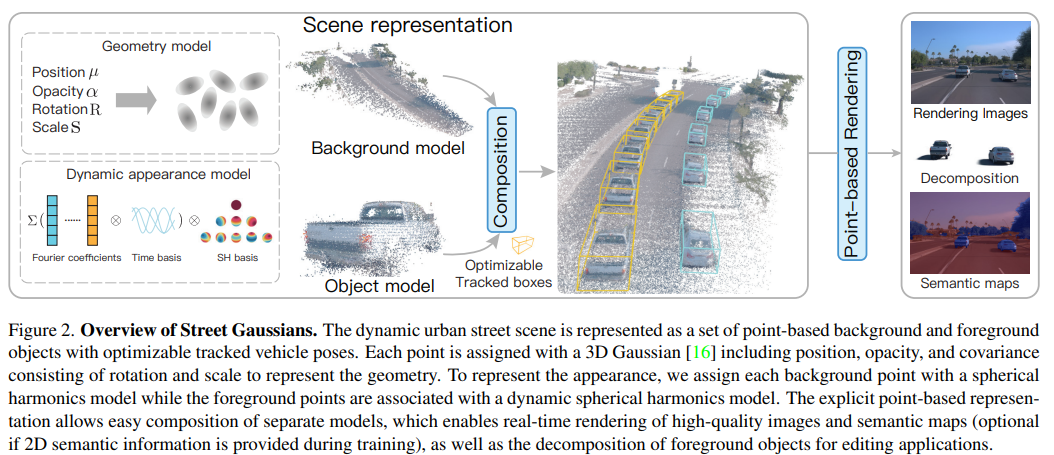

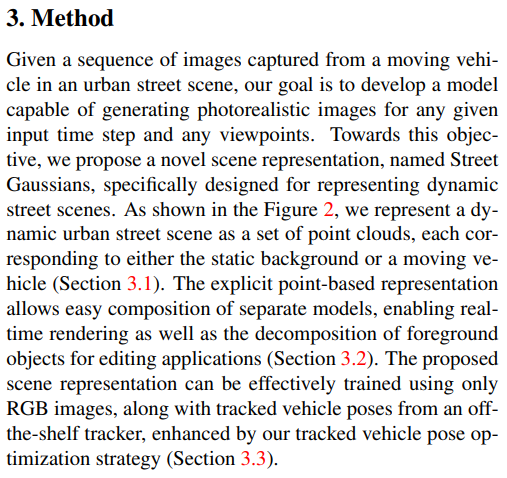

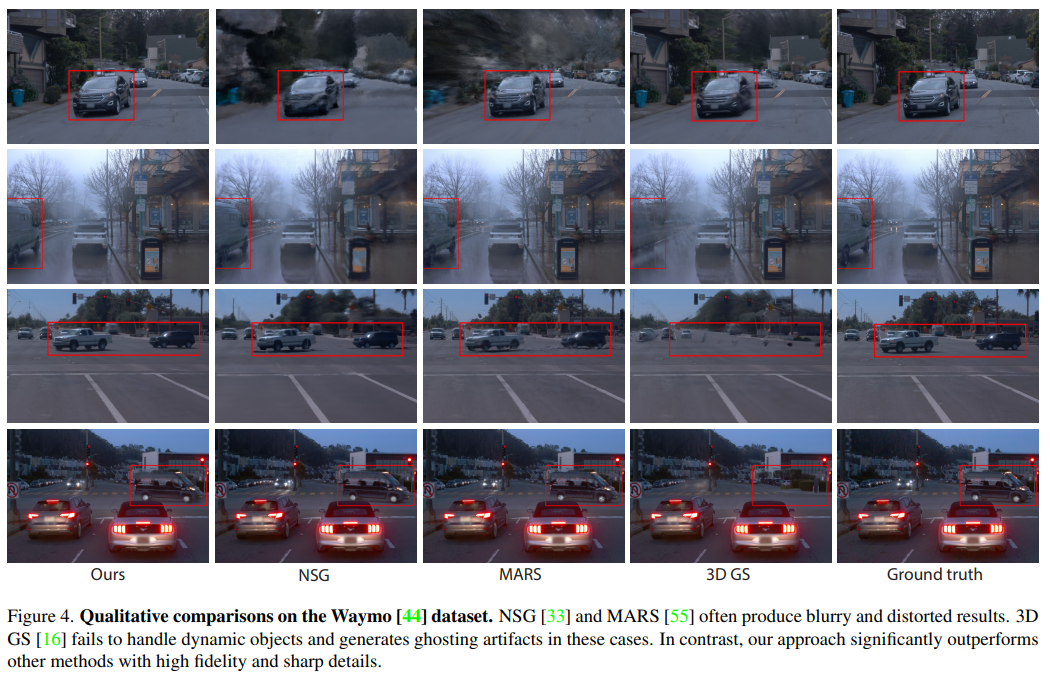

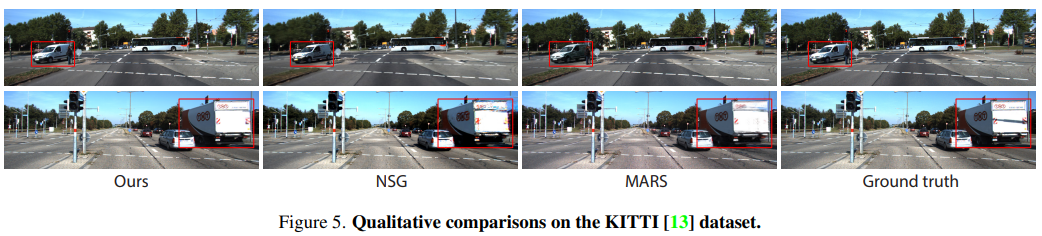

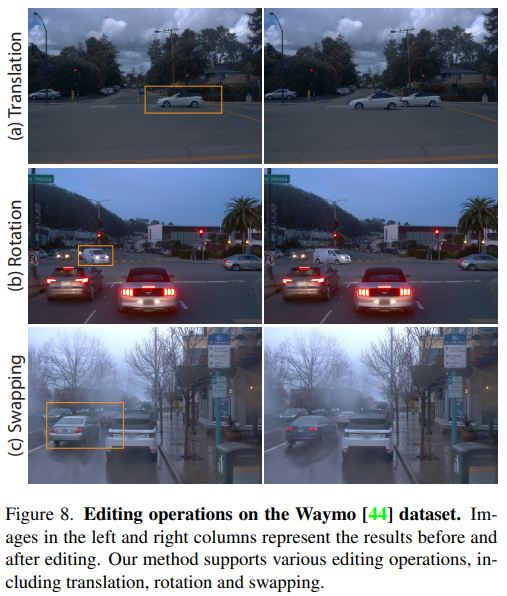

lidar point가 풍부하게 주어진 상황이다. sequence 충분히 촘촘하고 point density도 충분하다. 이 상황에서 3D bbox detector + tracker를 붙여 배경과 물체(차량)을 구분해서 GS로 복원한다. 이 때 물체는 움직이므로 time dimension까지 고려해서 4D로 구현하고 배경은 3D gs다. 복원이 완료되면 다양하게 주행 데이터셋을 찍어낼 수 있는 시뮬레이터 같이 쓸 수 있다. |

|

|

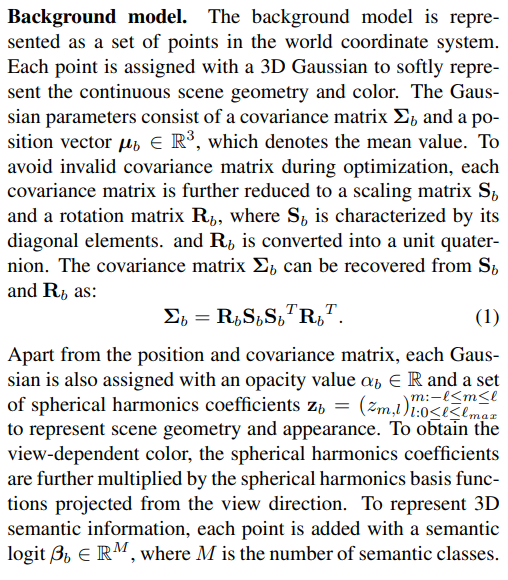

| 배경은 그냥 vanilla 3D GS 그대로 100% | 물체는 좌표계를 물체 좌표계 + 배경 좌표계 대비 물체 위치 (tracker가 뱉어줌) 으로 표현한다는 점 빼고는 대부분 3D GS와 같다. |

|

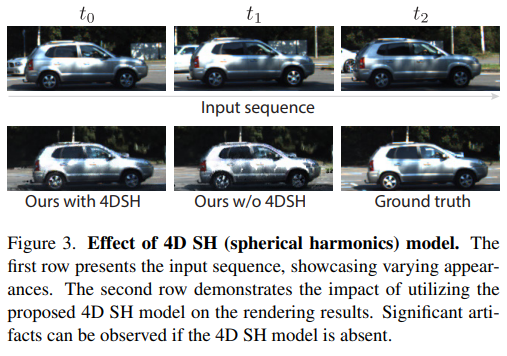

물체의 경우, 하나 더 다른 점이 움직이므로 4D로 표현해야 한다는 점인데 이를 모든 물체 point 마다 파라미터를 부여하면 용량 문제가 있으니 이를 간소화 하기 위해서 fourier transform을 활용했다. 직관적으로 말하면, 주어진 데이터의 모든 time, t에 대해서 파라미터를 각각 따로 구하는 것이 아니라 time, t에 따른 파라미터 변화를 signal로 보고 이 signal을 표현하는 DFT coefficient를 찾는 방법이다. signal을 알고 있으면 time, t의 파라미터는 읽으면 되는 것이기 때문이다. (이 부분 좋았다)  |

|

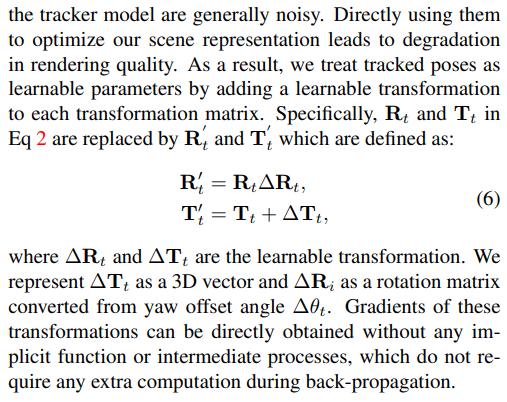

|

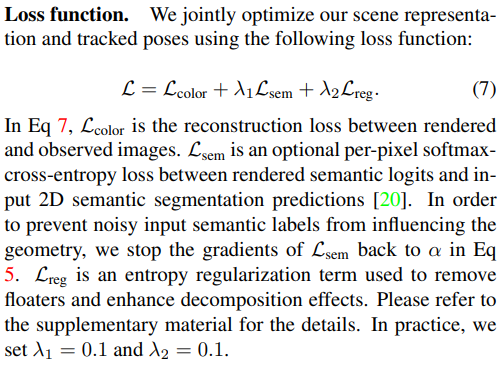

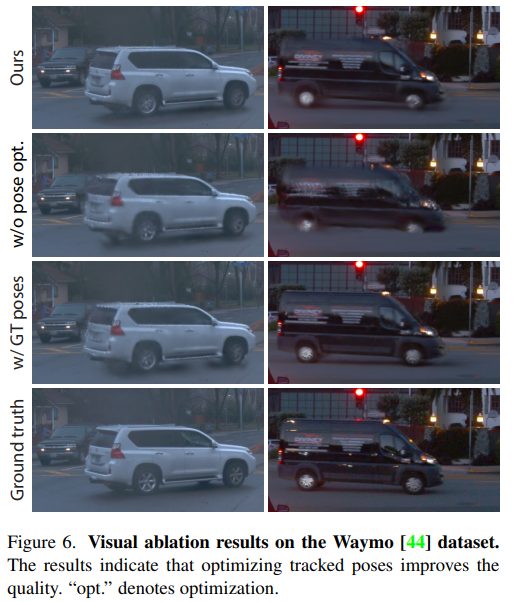

| 3D GS copy-and-paste | 물체 좌표계를 tracker에만 의존하면 tracker noise에 취약하므로, 물체마다 learnable residual을 두어 보정함. segmantation loss는 렌더링 결과의 semantic label도 얻고 싶어서 extra로 semantic label을 넣어둔 것 때문이다. 목적 자체가 데이터 생성용 시뮬레이터 여서 그런듯. |

|

|

|

|

|

|

반응형